Spracherkennung

Spracherkennung ist das interdisziplinäre Teilgebiet der Computerlinguistik, das Methoden und Technologien entwickelt, die die Erkennung und Übersetzung von gesprochenen Sprachen in Text durch Computer ermöglichen. Es ist auch als automatische Spracherkennung (ASR), Computer-Spracherkennung oder Sprachausgabe (STT) bekannt. Es umfasst Wissen und Forschung in den Bereichen Linguistik, Informatik und Elektrotechnik.

Einige Spracherkennungssysteme erfordern ein „Training“ (auch „Registrierung“ genannt), bei dem ein einzelner Sprecher Text oder isoliertes Vokabular in das System einliest. Das System analysiert die spezifische Stimme der Person und verwendet sie zur Feinabstimmung der Erkennung der Sprache dieser Person, was zu einer erhöhten Genauigkeit führt. Systeme, die keine Schulung verwenden, werden als sprecherunabhängige Systeme bezeichnet. Systeme, die Schulungen verwenden, werden als „sprecherabhängig“ bezeichnet.

Spracherkennungsanwendungen umfassen Sprachbenutzeroberflächen wie Sprachanwahl (z. B. „Ruf nach Hause“), Anrufweiterleitung (z. B. „Ich möchte einen Anruf tätigen“), Domotik-Appliance-Steuerung, Suche (z. B. Suchen eines Podcasts, in dem bestimmte Wörter gesprochen wurden ), einfache Dateneingabe (z. B. Eingabe einer Kreditkartennummer), Erstellung strukturierter Dokumente (z. B. Radiologiebericht), Sprach-zu-Text-Verarbeitung (z. B. Textverarbeitungsprogramme oder E-Mails) und Flugzeuge (üblicherweise als direkte Spracheingabe bezeichnet). .

Der Begriff Spracherkennung oder Sprecheridentifizierung bezieht sich auf die Identifizierung des Sprechers und nicht auf das, was er sagt. Das Erkennen des Sprechers kann die Übersetzung von Sprache in Systemen vereinfachen, die auf die Stimme einer bestimmten Person trainiert wurden, oder es kann zur Authentifizierung oder Überprüfung der Identität eines Sprechers als Teil eines Sicherheitsprozesses verwendet werden.

Aus technologischer Sicht hat Spracherkennung eine lange Geschichte mit mehreren Wellen von wichtigen Innovationen. In letzter Zeit profitierte der Bereich von den Fortschritten im Bereich des tiefen Lernens und von Big Data. Die Fortschritte werden nicht nur durch den Anstieg der in diesem Bereich veröffentlichten wissenschaftlichen Arbeiten belegt, sondern vor allem durch die weltweite Einführung einer Vielzahl tiefgreifender Lernmethoden beim Entwurf und Einsatz von Spracherkennungssystemen. Zu den Akteuren der Sprachbranche zählen Google, Microsoft, IBM, Baidu, Apple, Amazon, Nuance, SoundHound und iFLYTEK, von denen viele die Kerntechnologie in ihren Spracherkennungssystemen als tiefes Lernen bekannt gemacht haben.

Modelle, Methoden und Algorithmen

Sowohl die akustische Modellierung als auch die Sprachmodellierung sind wichtige Bestandteile moderner statistisch basierter Spracherkennungsalgorithmen. Hidden Markov-Modelle (HMMs) sind in vielen Systemen weit verbreitet. Die Sprachmodellierung wird auch in vielen anderen Anwendungen für die Verarbeitung natürlicher Sprache verwendet, z. B. zur Dokumentenklassifizierung oder zur statistischen maschinellen Übersetzung.

Versteckte Markov-Modelle

Moderne universelle Spracherkennungssysteme basieren auf Hidden-Markov-Modellen. Dies sind statistische Modelle, die eine Folge von Symbolen oder Größen ausgeben. HMMs werden bei der Spracherkennung verwendet, da ein Sprachsignal als stückweises stationäres Signal oder kurzzeitiges stationäres Signal angesehen werden kann. In einer kurzen Zeitskala (z. B. 10 Millisekunden) kann Sprache als stationärer Prozess angenähert werden. Sprache kann für viele stochastische Zwecke als Markov-Modell betrachtet werden.

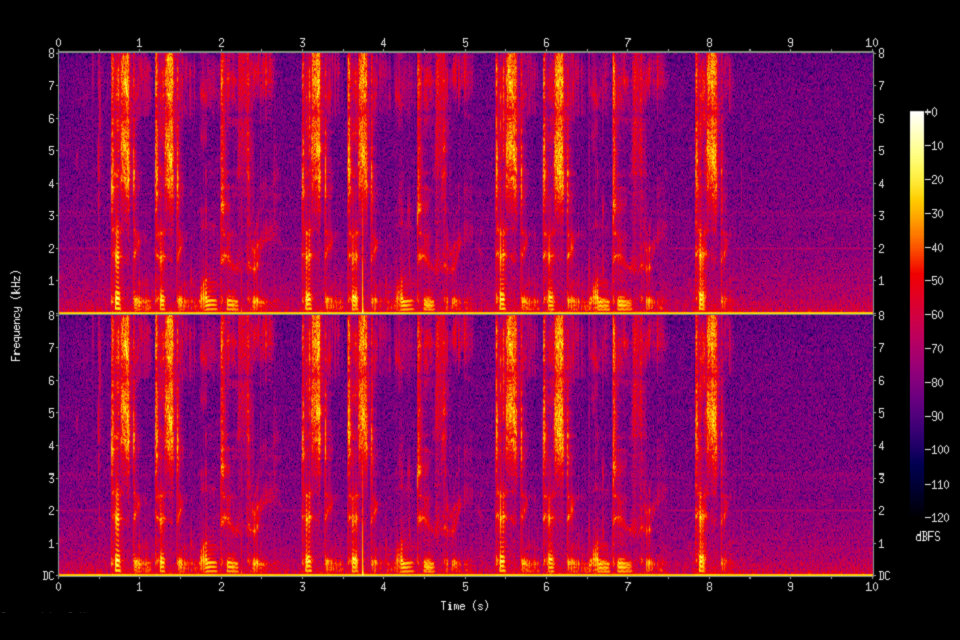

Ein weiterer Grund, warum HMMs beliebt sind, ist, dass sie automatisch trainiert werden können und einfach und rechenfähig sind. Bei der Spracherkennung würde das Hidden-Markov-Modell eine Folge von n-dimensionalen, realwertigen Vektoren ausgeben (wobei n eine kleine ganze Zahl wie 10 ist), wobei alle 10 Millisekunden einer von diesen ausgegeben wird. Die Vektoren würden aus Cepstral-Koeffizienten bestehen, die erhalten werden, indem eine Fourier-Transformation eines kurzen Zeitfensters der Sprache durchgeführt und das Spektrum unter Verwendung einer Cosinus-Transformation dekorreliert wird, und dann die ersten (höchstwertigen) Koeffizienten genommen werden. Das Hidden-Markov-Modell wird tendenziell in jedem Zustand eine statistische Verteilung aufweisen, die eine Mischung diagonaler Kovarianz-Gaußsche ist, was für jeden beobachteten Vektor eine Wahrscheinlichkeit ergibt. Jedes Wort oder (für allgemeinere Spracherkennungssysteme) jedes Phonem hat eine andere Ausgabeverteilung; Ein Hidden-Markov-Modell für eine Folge von Wörtern oder Phonemen wird durch Verketten der einzelnen trainierten Hidden-Markov-Modelle für die einzelnen Wörter und Phoneme erstellt.

Vorstehend sind die Kernelemente des häufigsten HMM-basierten Ansatzes zur Spracherkennung beschrieben. Moderne Spracherkennungssysteme verwenden verschiedene Kombinationen einer Anzahl von Standardtechniken, um die Ergebnisse gegenüber dem oben beschriebenen grundlegenden Ansatz zu verbessern. Ein typisches System mit großem Vokabular würde Kontextabhängigkeit für die Phoneme benötigen (Phoneme mit unterschiedlichem linken und rechten Kontext haben daher unterschiedliche Realisierungen als HMM-Zustände). Es würde die Cepstral-Normalisierung verwenden, um für unterschiedliche Lautsprecher- und Aufnahmebedingungen zu normalisieren. Für eine weitere Sprechernormierung kann es die Vocal-Tract-Längen-Normalisierung (VTLN) für die Normalisierung von Männern und Frauen und die lineare Regression (MLLR) für eine allgemeinere Sprecheranpassung verwenden. Die Merkmale hätten sogenannte Delta- und Delta-Delta-Koeffizienten, um die Sprachdynamik zu erfassen, und könnten zusätzlich die heteroskedastische lineare Diskriminanzanalyse (HLDA) verwenden; oder könnten die Delta- und Delta-Delta-Koeffizienten überspringen und Splicing und eine LDA-basierte Projektion verwenden, gefolgt von einer heteroscedastischen linearen Diskriminanzanalyse oder einer globalen semi-gebundenen Ko-Varianztransformation (auch als Maximum-Likelihood-Lineartransformation oder MLLT bezeichnet). Viele Systeme verwenden sogenannte diskriminative Trainingstechniken, die auf einen rein statistischen Ansatz für die HMM-Parameterschätzung verzichten und stattdessen ein klassifikationsbezogenes Maß der Trainingsdaten optimieren. Beispiele sind maximale gegenseitige Information (MMI), minimaler Klassifikationsfehler (MCE) und minimaler Telefonfehler (MPE).

Die Dekodierung der Sprache (der Begriff für das, was passiert, wenn das System mit einer neuen Äußerung versehen wird und den wahrscheinlichsten Quellsatz berechnen muss) würde wahrscheinlich den Viterbi-Algorithmus verwenden, um den besten Pfad zu finden, und hier besteht die Wahl zwischen der dynamischen Erzeugung eines Sprachs Kombiniertes Hidden-Markov-Modell, das sowohl die akustischen als auch die Sprachmodellinformationen enthält und zuvor statisch kombiniert (der Finite-State-Transducer oder FST-Ansatz).

Eine mögliche Verbesserung der Dekodierung besteht darin, eine Reihe guter Kandidaten zu behalten, anstatt nur den besten Kandidaten zu behalten, und eine bessere Bewertungsfunktion (Re-Scoring) zu verwenden, um diese guten Kandidaten zu bewerten, damit wir den besten gemäß dieser verfeinerten Bewertung auswählen können . Die Kandidatengruppe kann entweder als Liste (N-best-Listen-Ansatz) oder als Teilmenge der Modelle (Gitter) geführt werden. Bei der Neubewertung wird in der Regel versucht, das Bayes-Risiko (oder eine Annäherung davon) zu minimieren: Anstatt den Quellsatz mit maximaler Wahrscheinlichkeit zu nehmen, versuchen wir, den Satz zu verwenden, der die Erwartung einer bestimmten Verlustfunktion in Bezug auf alle möglichen Transkriptionen minimiert (dh wir nehmen den Satz, der die durchschnittliche Entfernung zu anderen möglichen Sätzen, gewichtet mit ihrer geschätzten Wahrscheinlichkeit, minimiert). Die Verlustfunktion ist normalerweise die Levenshtein-Distanz, obwohl es für bestimmte Aufgaben unterschiedliche Distanzen geben kann. Die Menge möglicher Transkriptionen wird natürlich beschnitten, um die Rückverfolgbarkeit aufrechtzuerhalten. Es wurden effiziente Algorithmen entwickelt, um Gitter, die als gewichtete Finite-State-Transducer dargestellt werden, neu zu bewerten, wobei die Editierabstände selbst als Finite-State-Transducer dargestellt werden, die bestimmte Annahmen überprüfen.

DTW-basierte Spracherkennung (Dynamic Time Warping)

Dynamisches Time Warping ist ein Ansatz, der in der Vergangenheit zur Spracherkennung verwendet wurde, jedoch durch den erfolgreicheren HMM-Ansatz weitgehend verdrängt wurde.

Dynamic Time Warping ist ein Algorithmus zum Messen der Ähnlichkeit zwischen zwei Sequenzen, deren Zeit oder Geschwindigkeit variieren kann. Zum Beispiel würden Ähnlichkeiten in den Laufmustern festgestellt, selbst wenn in einem Video die Person langsam ging und wenn sie in einem anderen schneller ging oder sogar Beschleunigungen und Verlangsamungen während einer Beobachtung auftraten. DTW wurde auf Video, Audio und Grafik angewendet. In der Tat können alle Daten, die in eine lineare Darstellung umgewandelt werden können, mit DTW analysiert werden.

Eine bekannte Anwendung war die automatische Spracherkennung, um mit unterschiedlichen Sprachgeschwindigkeiten umzugehen. Im Allgemeinen ist dies eine Methode, mit der ein Computer mit bestimmten Einschränkungen eine optimale Übereinstimmung zwischen zwei vorgegebenen Sequenzen (z. B. Zeitreihen) finden kann. Das heißt, die Sequenzen werden nichtlinear „verzerrt“, um sich aneinander anzupassen. Diese Sequenzausrichtungsmethode wird häufig im Kontext von Hidden-Markov-Modellen verwendet.

Neuronale Netze

Neuronale Netze entwickelten sich Ende der 80er Jahre als ein attraktiver Ansatz für die akustische Modellierung in ASR. Seitdem wurden neuronale Netze in vielen Aspekten der Spracherkennung verwendet, wie Phonemklassifizierung, Erkennung von isolierten Wörtern, audiovisuelle Spracherkennung, audiovisuelle Sprechererkennung und Sprecheranpassung.

Im Gegensatz zu HMMs machen neuronale Netzwerke keine Annahmen über statistische Eigenschaften von Merkmalen und besitzen mehrere Eigenschaften, die sie zu attraktiven Erkennungsmodellen für die Spracherkennung machen. Bei der Abschätzung der Wahrscheinlichkeiten eines Sprachmerkmalssegments ermöglichen neuronale Netzwerke auf natürliche und effiziente Weise diskriminatives Training. Bei neuronalen Netzen werden nur wenige Annahmen zur Statistik der Eingabemerkmale gemacht. Trotz ihrer Wirksamkeit bei der Klassifizierung von Kurzzeiteinheiten wie einzelnen Phonemen und isolierten Wörtern sind neuronale Netze für fortlaufende Erkennungsaufgaben selten erfolgreich, hauptsächlich aufgrund ihrer Unfähigkeit, zeitliche Abhängigkeiten zu modellieren.

Kürzlich wurden jedoch LSTM Recurrent Neural Networks (RNNs) und Time Delay Neural Networks (TDNNs) verwendet, von denen gezeigt wurde, dass sie latente zeitliche Abhängigkeiten identifizieren können und diese Informationen verwenden, um die Aufgabe der Spracherkennung auszuführen.

Um dieses Problem effektiv anzugehen, wurden auch mit Deep Neural Networks und Denoising Autoencoder experimentiert.

Aufgrund der Unfähigkeit von neuronalen Feedforward-Netzen, zeitliche Abhängigkeiten zu modellieren, besteht ein alternativer Ansatz darin, neuronale Netzwerke als Vorverarbeitung zu verwenden, z. B. Merkmalstransformation, Dimensionsreduzierung, für die HMM-basierte Erkennung.

Deep Feedforward und wiederkehrende neuronale Netze

Ein tiefes Feedforward Neuronales Netzwerk (DNN) ist ein künstliches neuronales Netzwerk mit mehreren verborgenen Schichten von Einheiten zwischen der Eingabe- und der Ausgabeschicht. Ähnlich wie flache neuronale Netze können DNNs komplexe nichtlineare Beziehungen modellieren. DNN-Architekturen generieren Kompositionsmodelle, bei denen zusätzliche Schichten die Zusammensetzung von Merkmalen aus unteren Schichten ermöglichen, wodurch eine enorme Lernkapazität ermöglicht wird und somit das Modellieren komplexer Muster von Sprachdaten möglich ist.

Ein Erfolg von DNNs in der Spracherkennung für große Vokabeln wurde 2010 von Industrieforschern in Zusammenarbeit mit akademischen Forschern erzielt, wo große Ausgabeschichten der DNN basierend auf kontextabhängigen HMM-Zuständen, die durch Entscheidungsbäume aufgebaut wurden, übernommen wurden. Ausführliche Berichte zu dieser Entwicklung und zum Stand der Technik vom Oktober 2014 finden Sie im aktuellen Springer-Buch von Microsoft Research. Siehe auch den verwandten Hintergrund der automatischen Spracherkennung und die Auswirkungen verschiedener Paradigmen des maschinellen Lernens, insbesondere tiefgreifendes Lernen in kürzlich erschienenen Übersichtsartikeln.

Ein grundlegendes Prinzip des tiefen Lernens besteht darin, auf das handwerkliche Feature-Engineering zu verzichten und rohe Features zu verwenden. Dieses Prinzip wurde erstmals erfolgreich in der Architektur des Deep Autoencoders an „rohen“ Spektrogramm- oder linearen Filterbank-Features untersucht, was seine Überlegenheit gegenüber den Mel-Cepstral-Features zeigt, die einige feste Transformationsschritte aus Spektrogrammen enthalten. In jüngster Zeit wurde gezeigt, dass die wahren „rohen“ Merkmale von Sprache, Wellenformen, hervorragende Spracherkennungsergebnisse in größerem Maßstab erzeugen.

Ende-zu-Ende automatische Spracherkennung

Seit 2014 besteht ein großes Forschungsinteresse an „End-to-End“ ASR. Traditionelle, auf Phonetik basierende Ansätze (dh alle HMM-basierten Modelle) erforderten separate Komponenten und ein Training für das Aussprache-, Akustik- und Sprachmodell. End-to-End-Modelle lernen gemeinsam alle Komponenten des Spracherkenners. Dies ist wertvoll, da es den Schulungsprozess und den Bereitstellungsprozess vereinfacht. Beispielsweise ist für alle HMM-basierten Systeme ein N-Gramm-Sprachmodell erforderlich, und ein typisches N-Gramm-Sprachmodell benötigt oft mehrere Gigabyte Speicher, was die Implementierung auf mobilen Geräten unmöglich macht. Daher werden moderne kommerzielle ASR-Systeme von Google und Apple (ab 2017) in der Cloud bereitgestellt und erfordern eine Netzwerkverbindung anstelle des Geräts lokal.

Der erste Versuch der End-to-End-ASR erfolgte mit Connectionist Temporal Classification (CTC) -basierten Systemen, die Alex Graves von Google DeepMind und Navdeep Jaitly von der University of Toronto 2014 eingeführt hatten. Das Modell bestand aus rekurrenten neuronalen Netzwerken und einer CTC-Schicht. Gemeinsam lernt das RNN-CTC-Modell die Aussprache und das Akustikmodell gemeinsam, kann jedoch die Sprache aufgrund bedingter Unabhängigkeitsannahmen, die einem HMM ähneln, nicht erlernen. Folglich können CTC-Modelle direkt lernen, Sprachakustik englischen Buchstaben zuzuordnen. Die Modelle machen jedoch viele häufige Schreibfehler, und sie müssen sich auf ein separates Sprachmodell stützen, um die Transkripte zu bereinigen. Später erweiterte Baidu die Arbeit mit extrem großen Datensätzen und zeigte kommerziellen Erfolg auf Chinesisch (Mandarin) und Englisch. Im Jahr 2016 präsentierte die University of Oxford LipNet, das erste durchgängige Lippenlesemodell auf Satzebene, das räumlich-zeitliche Konvolute in Verbindung mit einer RNN-CTC-Architektur verwendete und die Leistung des Menschen in einem eingeschränkten Grammatikdatensatz übertraf.

Ein alternativer Ansatz zu CTC-basierten Modellen sind auf Aufmerksamkeit basierende Modelle. Aufmerksamkeitsbasierte ASR-Modelle wurden gleichzeitig von Chan et al. Eingeführt. der Carnegie Mellon University und Google Brain und Bahdanaua et al. von der University of Montreal im Jahr 2016. Das Modell mit dem Namen „Listen, Attend and Spell“ (LAS) „hört“ wortwörtlich das akustische Signal, achtet auf verschiedene Teile des Signals und „zaubert“ das Transkript ein Zeichen aus zu einer Zeit Im Gegensatz zu CTC-basierten Modellen haben aufmerksamkeitsorientierte Modelle keine Annahmen zur bedingten Unabhängigkeit und können alle Komponenten eines Spracherkenners, einschließlich des Aussprache-, Akustik- und Sprachmodells, direkt erlernen. Dies bedeutet, dass während der Bereitstellung kein Sprachmodell mitgeführt werden muss, was die Implementierung in Anwendungen mit begrenztem Speicher sehr praktisch macht. Bis Ende 2016 waren die aufmerksamkeitsorientierten Modelle beachtlich erfolgreich, einschließlich einer Outperformance der CTC-Modelle (mit oder ohne externes Sprachmodell). Seit dem ursprünglichen LAS-Modell wurden verschiedene Erweiterungen vorgeschlagen. Latent Sequence Decompositions (LSD) wurde von der Carnegie Mellon University, dem MIT und Google Brain vorgeschlagen, um Unterworteinheiten direkt auszugeben, die natürlicher sind als englische Zeichen. University of Oxford und Google DeepMind erweiterten LAS um „Watch, Listen, Attend and Spell“ (WLAS), um Lippenlesen zu erzielen, die die Leistung auf menschlicher Ebene übertreffen.

Anwendungen

In-Car-Systeme

Typischerweise aktiviert eine manuelle Steuereingabe, beispielsweise mittels einer Fingersteuerung am Lenkrad, das Spracherkennungssystem, und dies wird dem Fahrer durch eine Audioaufforderung signalisiert. Nach der Audioaufforderung verfügt das System über ein „Hörfenster“, in dem es eine Spracheingabe zur Erkennung annehmen kann.

Mit einfachen Sprachbefehlen können Sie Anrufe einleiten, Radiosender auswählen oder Musik von einem kompatiblen Smartphone, MP3-Player oder einem mit Musik geladenen Flash-Laufwerk abspielen. Die Spracherkennungsfunktionen unterscheiden sich je nach Automarke und Modell. Einige der neuesten [when?] – Automodelle bieten anstelle einer festen Gruppe von Befehlen eine Spracherkennung in natürlicher Sprache, sodass der Fahrer vollständige Sätze und gebräuchliche Sätze verwenden kann. Bei solchen Systemen ist es daher nicht erforderlich, dass der Benutzer einen Satz fester Befehlswörter speichert.

Gesundheitsvorsorge

Medizinische Dokumentation

Im Gesundheitswesen kann die Spracherkennung im Front-End oder Back-End des medizinischen Dokumentationsprozesses implementiert werden. Front-End-Spracherkennung ist, wenn der Anbieter eine Spracherkennungs-Engine vorschreibt, die erkannten Wörter angezeigt werden, während sie gesprochen werden, und der Diktator für die Bearbeitung und das Abmelden des Dokuments verantwortlich ist. Bei der Back-End- oder der verzögerten Spracherkennung gibt der Anbieter ein digitales Diktiersystem vor, die Stimme wird durch eine Spracherkennungsmaschine geleitet, und das erkannte Entwurfsdokument wird zusammen mit der Original-Sprachdatei an den Bearbeiter weitergeleitet, wo der Entwurf bearbeitet wird und Bericht abgeschlossen. Gegenwärtig wird Spracherkennung in der Industrie häufig eingesetzt.

Eines der Hauptprobleme im Zusammenhang mit der Verwendung der Spracherkennung im Gesundheitswesen ist, dass das American Recovery and Reinvestment Act von 2009 (ARRA) Ärzten erhebliche finanzielle Vorteile bietet, wenn sie eine EMR gemäß den Standards für „Meaningful Use“ verwenden. Diese Standards setzen voraus, dass eine beträchtliche Datenmenge von der EMR (jetzt häufiger als elektronische Gesundheitsakte oder EHR bezeichnet) verwaltet wird. Die Verwendung der Spracherkennung eignet sich natürlicher für die Erzeugung von narrativem Text als Teil einer Interpretation, Fortschrittsnotiz oder Entlassungszusammenfassung für Radiologie / Pathologie: Die ergonomischen Vorteile der Verwendung der Spracherkennung zur Eingabe strukturierter diskreter Daten (z. B. numerische Werte oder Codes) von einer Liste oder einem kontrollierten Vokabular) sind relativ gering für sehbehinderte Menschen, die Tastatur und Maus bedienen können.

Ein bedeutsameres Problem ist, dass die meisten EHRs nicht ausdrücklich auf die Spracherkennungsfunktionen zugeschnitten wurden. Ein großer Teil der Interaktion des Klinikers mit der EHR umfasst die Navigation über die Benutzeroberfläche mithilfe von Menüs sowie das Klicken auf Tab / Button und ist stark von Tastatur und Maus abhängig: Die sprachbasierte Navigation bietet nur geringe ergonomische Vorteile. Im Gegensatz dazu implementieren viele hochgradig angepasste Systeme für das radiologische oder pathologische Diktat Sprach- „Makros“, bei denen die Verwendung bestimmter Ausdrücke – z. B. „normaler Bericht“ – automatisch eine große Anzahl von Standardwerten ausfüllt und / oder eine Boilerplate generiert, die dies ermöglicht je nach Art der Untersuchung variieren – z. B. eine Thorax-Röntgenaufnahme im Vergleich zu einer gastrointestinalen Kontrastserie für ein radiologisches System.

Als Alternative zu dieser Handnavigation wurde die kaskadierte Verwendung von Spracherkennung und Informationsgewinnung als Möglichkeit zum Ausfüllen eines Übergabeformulars für klinische Korrekturen und Abnahmen untersucht. Die Ergebnisse sind ermutigend, und der Beitrag öffnet der Forschungs- und Entwicklungsgemeinschaft auch Daten mit den zugehörigen Leistungsbenchmarks und einiger Verarbeitungssoftware, um klinische Dokumentation und Sprachverarbeitung zu studieren.

Therapeutische Verwendung

Ein längerer Einsatz von Spracherkennungssoftware in Verbindung mit Textverarbeitungsprogrammen hat gezeigt, dass die Wiederherstellung des Kurzzeitgedächtnisses bei AVM-Patienten im Gehirn, die mit Resektion behandelt wurden, von Vorteil ist. Weitere Forschungen müssen durchgeführt werden, um den kognitiven Nutzen für Personen zu bestimmen, deren AVM mit radiologischen Techniken behandelt wurden.

Militär

Hochleistungskampfflugzeug

In den letzten zehn Jahren wurden beträchtliche Anstrengungen unternommen, um die Spracherkennung in Kampfflugzeugen zu testen und zu bewerten. Besonders hervorzuheben sind das US-amerikanische Programm zur Spracherkennung für die Flugzeuge Advanced Fighter Technology Integration (AFTI) / F-16 (F-16 VISTA), das Programm in Frankreich für Mirage-Flugzeuge und andere Programme in Großbritannien, die sich mit einer Vielzahl von Varianten befassen von Flugzeugplattformen. In diesen Programmen wurden Spracherkenner erfolgreich in Kampfflugzeugen eingesetzt, unter anderem zum Einstellen von Funkfrequenzen, zum Steuern eines Autopilotsystems, zum Einstellen von Lenkpunktkoordinaten und Waffenfreigabeparametern und zum Steuern der Fluganzeige.

In Zusammenarbeit mit schwedischen Piloten, die im Cockpit des JAS-39 Gripen flogen, stellte Englund (2004) fest, dass sich die Anerkennung mit zunehmenden G-Lasten verschlechterte. Der Bericht kam auch zu dem Schluss, dass die Ergebnisse in allen Fällen durch die Anpassung erheblich verbessert wurden und dass die Einführung von Atmungsmodellen die Erkennungswerte deutlich verbessert. Entgegen den Erwartungen wurden keine Auswirkungen des gebrochenen Englisch der Sprecher festgestellt. Es war offensichtlich, dass die spontane Rede erwartungsgemäß Probleme für den Erkenner verursachte. Man könnte also erwarten, dass ein eingeschränktes Vokabular und vor allem eine richtige Syntax die Erkennungsgenauigkeit wesentlich verbessern.

Der Eurofighter Typhoon, der derzeit bei der britischen Luftfahrtbehörde RAF im Einsatz ist, verwendet ein sprecherabhängiges System, sodass jeder Pilot eine Vorlage erstellen muss. Das System wird nicht für sicherheitskritische oder waffenkritische Aufgaben wie das Auslösen der Waffe oder das Absenken des Unterwagens verwendet, sondern für eine Vielzahl anderer Cockpitfunktionen. Sprachbefehle werden durch visuelle und / oder akustische Rückmeldung bestätigt. Das System wird als wesentliches Konstruktionsmerkmal für die Verringerung der Arbeitsbelastung des Piloten angesehen und ermöglicht es dem Piloten sogar, seinem Flugzeug mit zwei einfachen Sprachbefehlen oder mit nur fünf Befehlen einem seiner Flügelmenschen Ziele zuzuweisen.

Für den F35 Lightning II (JSF) und den Alenia Aermacchi M-346 Master-Einstiegskampftrainer werden auch sprecherunabhängige Systeme entwickelt und getestet. Diese Systeme haben zu Wortgenauigkeitswerten von über 98% geführt.

Hubschrauber

Die Probleme, eine hohe Erkennungsgenauigkeit unter Stress und Lärm zu erreichen, betreffen sowohl die Hubschrauberumgebung als auch die Umgebung des Düsenjägers. Das akustische Geräuschproblem ist in der Hubschrauberumgebung tatsächlich schwerwiegender, nicht nur wegen des hohen Geräuschpegels, sondern auch weil der Hubschrauberpilot im Allgemeinen keine Gesichtsmaske trägt, was das akustische Geräusch im Mikrofon reduzieren würde. In den letzten zehn Jahren wurden umfangreiche Test- und Evaluierungsprogramme in Anwendungen für Spracherkennungssysteme in Hubschraubern durchgeführt, insbesondere von der US-amerikanischen Avionik-Forschungs- und Entwicklungstätigkeit (AVRADA) und dem Royal Aerospace Establishment (RAE) in Großbritannien. Die Arbeit in Frankreich umfasst die Spracherkennung im Puma-Hubschrauber. Auch in Kanada hat es viele nützliche Arbeiten gegeben. Die Ergebnisse waren ermutigend, und Sprachanwendungen umfassten die Steuerung von Kommunikationsradios, das Einstellen von Navigationssystemen und die Steuerung eines automatisierten Zielübergabesystems.

Wie bei Kampfflugzeugen ist das Hauptproblem bei Hubschraubern die Auswirkung auf die Wirksamkeit des Piloten. Für die AVRADA-Tests werden ermutigende Ergebnisse berichtet, die jedoch nur eine Machbarkeitsstudie in einer Testumgebung darstellen. Sowohl bei der Spracherkennung als auch bei der gesamten Sprachtechnologie bleibt noch viel zu tun, um die Leistungsverbesserungen im betrieblichen Umfeld konstant zu erreichen.

Ausbildung von Fluglotsen

Das Training für Fluglotsen (ATC) ist eine hervorragende Anwendung für Spracherkennungssysteme. In vielen ATC-Schulungssystemen ist es derzeit erforderlich, dass eine Person als „Pseudopilot“ fungiert und in einen Sprachdialog mit dem Flugschüler-Controller eintritt, der den Dialog simuliert, den der Controller in einer echten ATC-Situation mit Piloten führen müsste. Spracherkennungs- und -synthesetechniken bieten die Möglichkeit, dass eine Person nicht als Pseudopilot fungiert, wodurch das Schulungs- und Unterstützungspersonal reduziert wird. Theoretisch sind Luftregleraufgaben auch durch stark strukturierte Sprache als primäres Ausgangssignal des Steuergeräts gekennzeichnet, so dass die Schwierigkeit der Spracherkennungsaufgabe reduziert werden sollte. In der Praxis ist dies selten der Fall. Das FAA-Dokument 7110.65 enthält die Phrasen, die von Fluglotsen verwendet werden sollten. Während dieses Dokument weniger als 150 Beispiele für solche Phrasen enthält, liegt die Anzahl der Phrasen, die von einem der Spracherkennungssysteme des Simulationsanbieters unterstützt werden, bei über 500.000.

Die USAF, USMC, US Army, US Navy und FAA sowie eine Reihe internationaler ATC-Trainingsorganisationen wie die Royal Australian Air Force und Zivilluftfahrtbehörden in Italien, Brasilien und Kanada verwenden derzeit ATC-Simulatoren mit Spracherkennung von eine Reihe verschiedener Anbieter.

Telefonie und andere Domains

ASR ist im Bereich der Telefonie mittlerweile alltäglich und wird im Bereich Computerspiele und Simulation immer weiter verbreitet. Trotz des hohen Integrationsgrades bei der Textverarbeitung im Allgemeinen Personal Computing. Die ASR im Bereich der Dokumentenproduktion hat jedoch nicht die erwartete Erhöhung [von wem?] Gesehen.

Die Verbesserung der Geschwindigkeit mobiler Prozessoren hat die Spracherkennung bei Smartphones praktisch gemacht. Sprache wird meistens als Teil einer Benutzeroberfläche verwendet, um vordefinierte oder benutzerdefinierte Sprachbefehle zu erstellen. Führende Softwareanbieter in diesem Bereich sind: Google, Microsoft Corporation (Microsoft Voice Command), Digital Siphon (Sonic Extractor), LumenVox, Nuance Communications (Nuance-Sprachsteuerung), Voci Technologies, VoiceBox-Technologie, Speech Technology Center, Vito Technologies (VITO Voice2Go) ), Speereo Software (Speereo Voice Translator), Verbyx VRX und SVOX.

Einsatz in Bildung und Alltag

Für das Sprachenlernen kann Spracherkennung für das Erlernen einer zweiten Sprache hilfreich sein. Es kann die richtige Aussprache lehren und zusätzlich dazu beitragen, dass die Person mit ihren Sprechfähigkeiten fließender wird.

Schüler, die blind sind (siehe Blindheit und Bildung) oder sehr sehbehindert sind, können von der Technologie zum Übertragen von Wörtern profitieren und dann hören, wie der Computer sie rezitiert, oder einen Computer verwenden, indem sie mit ihrer Stimme befehlen, anstatt sich das anzusehen der Bildschirm und die Tastatur.

Schüler, die körperlich behindert sind oder an wiederholten Belastungsverletzungen oder anderen Verletzungen der oberen Extremitäten leiden, können sich durch die Verwendung von Sprach-zu-Text-Programmen die Möglichkeit nehmen, sich um das Schreiben, Schreiben oder Schreiben mit Schreiberarbeiten zu kümmern. Sie können die Spracherkennungstechnologie auch verwenden, um das Internet zu durchsuchen oder zu Hause einen Computer zu verwenden, ohne Maus und Tastatur bedienen zu müssen.

Spracherkennung kann Schülern mit Lernschwierigkeiten zu besseren Schreibern verhelfen. Indem sie die Worte laut aussprechen, können sie die Fließfähigkeit ihres Schreibens erhöhen und von Bedenken hinsichtlich Rechtschreibung, Satzzeichen und anderen Schreibmechanismen gemildert werden. Siehe auch Lernbehinderung.

Die Verwendung von Spracherkennungssoftware in Verbindung mit einem digitalen Audiorecorder und einem Personalcomputer, auf dem eine Textverarbeitungssoftware ausgeführt wird, hat sich bei der Wiederherstellung beschädigter Kurzzeitspeicherfähigkeit bei Personen mit Schlaganfall und Kraniotomie als positiv erwiesen.

Menschen mit Behinderungen

Menschen mit Behinderungen können von Spracherkennungsprogrammen profitieren. Für Personen, die taub oder schwerhörig sind, wird eine Spracherkennungssoftware verwendet, um automatisch Untertitel von Konversationen zu generieren, z. B. Diskussionen in Konferenzräumen, Vorlesungen im Klassenzimmer und / oder religiöse Dienste.

Spracherkennung ist auch sehr nützlich für Menschen, die Schwierigkeiten beim Umgang mit den Händen haben, von leichten wiederholten Stressverletzungen bis hin zu Behinderungen, die die Verwendung herkömmlicher Computereingabegeräte ausschließen. Tatsächlich wurden Leute, die viel mit der Tastatur arbeiteten und RSI entwickelten, zu einem dringenden frühen Markt für Spracherkennung. Die Spracherkennung wird bei tauben Telefonen verwendet, wie z. B. Voicemail für Text, Weiterleitungsdienste und Telefon mit Untertitel. Personen mit Lernbehinderungen, die Probleme mit der Kommunikation auf Papier haben (im Wesentlichen denken sie an eine Idee, die jedoch falsch verarbeitet wird, was dazu führt, dass sie auf Papier anders aussieht), können möglicherweise von der Software profitieren, die Technologie ist jedoch nicht fehlerfrei. Auch die ganze Idee, mit Text zu sprechen, kann für intellektuell behinderte Menschen schwierig sein, da es selten vorkommt, dass jemand versucht, die Technologie zu erlernen, um die Person mit der Behinderung zu unterrichten.

Diese Art von Technologie kann Menschen mit Legasthenie helfen, andere Behinderungen sind jedoch immer noch in Frage. Die Wirksamkeit des Produkts ist das Problem, das seine Wirksamkeit behindert. Obwohl ein Kind in der Lage ist, ein Wort zu sagen, hängt es davon ab, wie klar es ist, dass die Technologie möglicherweise ein anderes Wort sagt und ein falsches Wort eingibt. Wenn Sie mehr Arbeit für die Korrektur erhalten, müssen Sie mehr Zeit für die Korrektur des falschen Wortes auf sich nehmen.

Weitere Anwendungen

Luft- und Raumfahrt (z. B. Weltraumforschung, Raumsonden usw.) Der Mars Polar Lander der NASA setzte Spracherkennungstechnologie von Sensory, Inc. im Mars Microphone on the Lander ein

Automatische Untertitel mit Spracherkennung

Automatische Emotionserkennung

Automatische Übersetzung

Gerichtsberichterstattung (Echtzeit-Reden schreiben)

eDiscovery (rechtliche Entdeckung)

Freisprechen: Computerbenutzeroberfläche für Spracherkennung

Heimautomatisierung

Interaktive Sprachausgabe

Mobiltelefonie einschließlich mobiler E-Mail

Multimodale Interaktion

Bewertung der Aussprache in computergestützten Sprachlernanwendungen

Echtzeit-Untertitel

Robotik

Rede zum Text (Transkription der Rede in Text, Videotitel, Gerichtsberichterstattung)

Telematik (zB Fahrzeugnavigationssysteme)

Transkription (digitale Sprachausgabe)

Videospiele, mit Tom Clancy’s EndWar und Lifeline als Arbeitsbeispiele

Virtueller Assistent (z. B. Siri von Apple)

Performance

Die Leistung von Spracherkennungssystemen wird normalerweise in Bezug auf Genauigkeit und Geschwindigkeit bewertet. Die Genauigkeit wird normalerweise mit der Wortfehlerrate (WER) bewertet, während die Geschwindigkeit mit dem Echtzeitfaktor gemessen wird. Andere Genauigkeitsmaße umfassen die Einzelwortfehlerrate (SWER) und die Befehlserfolgsrate (Command Success Rate, CSR).

Die maschinelle Spracherkennung ist jedoch ein sehr komplexes Problem. Vokalisationen variieren in Bezug auf Akzent, Aussprache, Artikulation, Rauheit, Nasalität, Tonhöhe, Lautstärke und Geschwindigkeit. Die Sprache wird durch Hintergrundgeräusche und Echos sowie elektrische Eigenschaften verzerrt. Die Genauigkeit der Spracherkennung kann mit folgenden Angaben variieren:

Wortschatzgröße und Verwirrbarkeit

Abhängigkeit der Sprecher gegenüber der Unabhängigkeit

Isolierte, unterbrochene oder fortlaufende Sprache

Aufgaben- und Spracheinschränkungen

Lesen Sie gegen spontane Rede

Widrige Bedingungen