Emotionserkennung ist der Prozess der Erkennung menschlicher Emotionen, meistens aus Gesichtsausdrücken sowie aus verbalen Ausdrücken. Dies ist etwas, was Menschen automatisch tun, aber es wurden auch Berechnungsmethoden entwickelt.

Wissenschaftliche Definition Emotion

Eine Emotion muss von dem Begriff Gefühl, Stimmung und Persönlichkeit unterschieden werden. Ein Gefühl ist zum Beispiel, wenn Sie eine maskierte Person hinter einer Wand fühlen. Dann fühlst du Angst. Ein Gefühl wird erst zur Emotion, wenn diese körperliche Veränderung kognitiv bewertet wird.

Wenn jemand zum Beispiel seinen Herzschlag auf den maskierten Mann zurückführt, spricht man von Angst. Wenn er jedoch zu seiner heimlich Geliebten zurückkehrt, spricht man von Freude. Emotionen dauern in der Regel nur wenige Sekunden und haben einen klar definierten Ein-und Versatz. Stimmungen hingegen können Stunden, Tage oder sogar Wochen dauern. Wenn jemand sagt, dass er heute schlecht gelaunt ist, ist er schlecht gelaunt. Dies hat jedoch nicht unbedingt etwas mit Emotionen zu tun.

Oft kann eine bestimmte Stimmung die Wahrscheinlichkeit des Auftretens einer bestimmten Emotion erhöhen oder verringern, doch diese beiden Dinge müssen analytisch getrennt werden. Schließlich muss die Persönlichkeit einer Person von der Stimmung unterschieden werden. Ein Choleriker zum Beispiel ist permanent negativ aufgeregt. Auf diese Weise kann man sich die auf einer Zeitleiste angeordneten Begriffe Gefühl, Emotion, Stimmung und Persönlichkeit vorstellen – einerseits Gefühl, kurzfristig und andererseits langfristig.

Mensch

Menschen zeigen universelle Beständigkeit beim Erkennen von Emotionen, zeigen aber auch eine große Variabilität zwischen den einzelnen Personen in ihren Fähigkeiten. Dies war ein Hauptthema der Psychologie.

Cross Race-Effekt

Die emotionale Anerkennung zwischen zwei Menschen unterliegt starken Schwankungen. In der Psychologie wurde ein Phänomen entdeckt, das als Cross-Race-Effekt bezeichnet wird. Dieses Phänomen impliziert, dass die Emotionserkennungsrate niedriger ist, wenn die zu erkennende Emotion zu einem Gesicht gehört, das nicht zu derselben Kultur oder Ethnie gehört wie die des Beobachters. Dieser Effekt kann jedoch durch eine Trainingsform überwunden werden.

Visual Mimic Recognition

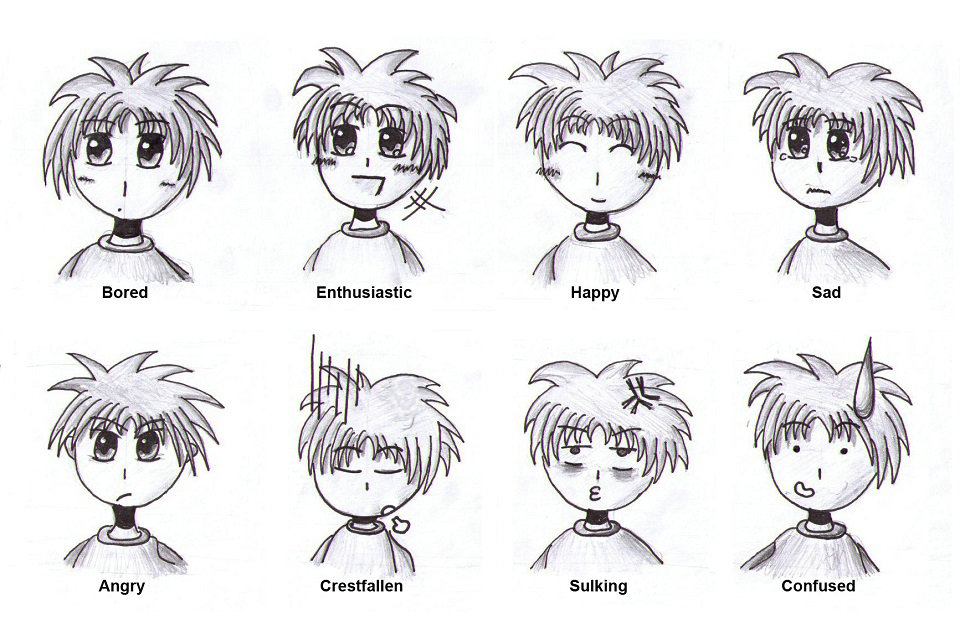

Dieser Teil wird allgemein als Gesichtsausdruck bezeichnet. Als Mensch-Maschine-Schnittstelle wird eine digitale Videokamera oder ein gleichwertiges optisches Eingabegerät verwendet. Hier werden die Methoden der Gesichtserkennung verwendet, um die Eigenschaften der Gesichtsoberfläche zu analysieren. Durch die automatische Klassifizierung ist es möglich, die Gesichtsausdrücke der seriellen Rahmen mit einem Cluster zu verknüpfen, der möglicherweise mit einer Emotion verbunden ist. Untersuchungen haben jedoch gezeigt, dass nur 30% der Mimik-Emotionen den wirklich empfundenen Emotionen entsprechen. Daher sollte man visuelle Gesichtsausdrücke nicht mit visueller Emotionserkennung gleichsetzen. Der biologische Hintergrund der visuellen Emotionserkennung ist die Simulation eines menschlichen Sehnervs in einem Roboter.

Emotion Induktion

Für experimentelle Einstellungen in den Bereichen Emotionspsychologie, Verhaltensethologie, Neuropsychologie und vielen anderen Wissenschaften ist es oft wichtig, unter Laborbedingungen bestimmte Emotionen zu „erzeugen“. Emotionale Induktion ist einer der schwierigsten Bereiche der emotionalen Forschung. Mehrere Metaanalysen zu diesem Thema haben mehrere Methoden extrahiert, die Emotionen am effektivsten auslösen können.

In erster Linie ist das Erfassen von Emotionen in der Realität (Stichwortfeldforschung). Aufgrund der geringen internen Validität wird häufig auf diese verzichtet. Die zweite Methode, die ein hohes Inneres mit einer hohen äußeren Gültigkeit verbindet, ist die Methode der emotionalen Erinnerung, bei der versucht wird, Erinnerungen aus dem Emotionsgedächtnis hervorzurufen. Für Experimente außerhalb der EEG-Emotionsforschung wird von Induktionsmethoden wie der IAPS oder der Induktionsmethode abgeraten, die angeblich emotionsinduzierende Filmsequenzen oder Musikstücke verwenden. Alle diese Methoden bleiben ohne Nachweis der spezifischen Wirksamkeit. Die Robotik verwendet häufig idealisierte experimentelle Verfahren, z.

Eine Induktionsmethode soll beim Menschen Emotionen hervorrufen.

Der Mensch drückt sein Gefühl mit einer veränderten Gesichtsoberfläche aus.

Eine Webcam am Computer erfasst den neuen Gesichtsausdruck.

Der Computer kann die Emotion automatisch klassifizieren, indem er sie als zuvor induzierte Emotion einstuft.

Nach Abschluss der Lernphase sollte die KI in der Lage sein, Emotionen unabhängig zu erkennen, ohne zuvor von einem Menschen unterrichtet worden zu sein. Da jedoch weder die Induktionsmethode häufig auf Wirksamkeit getestet wird, noch die induzierten Emotionen während des Experiments selbst bewertet werden, bleiben diese idealisierten experimentellen Verfahren in der Robotik oft fehlerhaft und unvollständig.

Automatik

Dieser Prozess nutzt Techniken aus verschiedenen Bereichen wie Signalverarbeitung, maschinelles Lernen und Computer Vision. Für die Interpretation von Emotionen können verschiedene Methoden und Techniken verwendet werden, z. B. Bayes-Netzwerke, Gaußsche Mixture-Modelle und Hidden-Markov-Modelle.

Ansätze

Die Aufgabe der Emotionserkennung beinhaltet häufig die Analyse menschlicher Ausdrücke in multimodalen Formen wie Texten, Audio oder Video. Unterschiedliche Emotionstypen werden durch die Integration von Informationen aus Gesichtsausdrücken, Körperbewegungen und Gesten sowie Sprache erkannt. Die bestehenden Ansätze in der Emotionserkennung zur Klassifizierung bestimmter Emotionstypen können im Allgemeinen in drei Hauptkategorien unterteilt werden: wissensbasierte Techniken, statistische Methoden und hybride Ansätze.

Wissensbasierte Techniken

Wissensbasierte Techniken (manchmal als lexikonbasierte Techniken bezeichnet) nutzen Domänenwissen und die semantischen und syntaktischen Merkmale der Sprache, um bestimmte Emotionstypen zu erkennen. Bei diesem Ansatz ist es üblich, während des Emotionsklassifizierungsprozesses wissensbasierte Ressourcen wie WordNet, SenticNet, ConceptNet und EmotiNet zu verwenden, um nur einige zu nennen. Einer der Vorteile dieses Ansatzes ist die Erreichbarkeit und Wirtschaftlichkeit, die durch die große Verfügbarkeit solcher wissensbasierten Ressourcen erreicht wird. Eine Einschränkung dieser Technik ist jedoch die Unfähigkeit, mit Konzeptnuancen und komplexen linguistischen Regeln umzugehen.

Wissensbasierte Techniken lassen sich hauptsächlich in zwei Kategorien einteilen: wörterbuchbasierte und korpusbasierte Ansätze. Wörterbuchbasierte Ansätze finden Meinungs- oder Gefühlssamenwörter in einem Wörterbuch und suchen nach ihren Synonymen und Antonyme, um die ursprüngliche Liste der Meinungen oder Emotionen zu erweitern. Korpusbasierte Ansätze beginnen dagegen mit einer Samenliste von Meinungen oder Emotionswörtern und erweitern die Datenbank, indem sie andere Wörter mit kontextspezifischen Merkmalen in einem großen Korpus finden. Während bei korpusbasierten Ansätzen der Kontext berücksichtigt wird, ist ihre Leistung in verschiedenen Bereichen noch unterschiedlich, da ein Wort in einer Domäne in einer anderen Domäne eine andere Ausrichtung haben kann.

Statistische Methoden

Statistische Verfahren beinhalten im Allgemeinen die Verwendung verschiedener beaufsichtigter maschineller Lernalgorithmen, bei denen eine große Menge kommentierter Daten in die Algorithmen eingegeben wird, damit das System die geeigneten Emotionstypen lernen und vorhersagen kann. Dieser Ansatz beinhaltet normalerweise zwei Datensätze: den Trainingssatz und den Testsatz, wobei der erstere zum Lernen der Attribute der Daten verwendet wird, während der zweite zur Validierung der Leistung des Maschinenlernalgorithmus verwendet wird. Algorithmen für maschinelles Lernen bieten im Vergleich zu anderen Ansätzen im Allgemeinen eine vernünftigere Klassifizierungsgenauigkeit. Eine der Herausforderungen bei der Erzielung guter Ergebnisse im Klassifizierungsprozess besteht jedoch in der Notwendigkeit eines ausreichend großen Trainingssatzes.

Zu den am häufigsten verwendeten Algorithmen für maschinelles Lernen zählen Support Vector Machines (SVM), Naive Bayes und Maximum Entropy. Deep Learning, das zur unüberwachten Familie des maschinellen Lernens gehört, wird auch häufig zur Emotionserkennung eingesetzt. Bekannte Algorithmen für den tiefen Lernprozess umfassen verschiedene Architekturen des künstlichen neuronalen Netzwerks (ANN), beispielsweise das Convolutional Neural Network (CNN), den Long Short-Term Memory (LSTM) und die Extreme Learning Machine (ELM). Die Beliebtheit von Deep-Learning-Ansätzen im Bereich der Emotionserkennung wird möglicherweise vor allem auf den Erfolg in verwandten Anwendungen wie Computer Vision, Spracherkennung und Natural Language Processing (NLP) zurückgeführt.

Hybride Ansätze

Hybride Ansätze bei der Emotionserkennung sind im Wesentlichen eine Kombination aus wissensbasierten Techniken und statistischen Methoden, die komplementäre Merkmale beider Techniken nutzen. Zu den Werken, die ein Ensemble von wissensgesteuerten sprachlichen Elementen und statistischen Methoden angewendet haben, gehören Sentic Computing und iFeel, die beide die wissensbasierte Ressource SenticNet auf Konzeptebene übernommen haben. Die Rolle dieser wissensbasierten Ressourcen bei der Implementierung hybrider Ansätze ist für den Emotionsklassifizierungsprozess von großer Bedeutung. Da Hybridtechniken von den Vorteilen profitieren, die sowohl wissensbasierte als auch statistische Ansätze bieten, weisen sie tendenziell eine bessere Klassifizierungsleistung auf, anstatt wissensbasierte oder statistische Methoden unabhängig voneinander einzusetzen. Ein Nachteil der Verwendung von Hybridtechniken ist jedoch die rechnerische Komplexität während des Klassifizierungsprozesses.

Datensätze

Daten sind ein integraler Bestandteil der bestehenden Ansätze bei der Emotionserkennung. In den meisten Fällen ist es eine Herausforderung, kommentierte Daten zu erhalten, die zum Trainieren von Algorithmen für maschinelles Lernen erforderlich sind. Während die meisten öffentlich verfügbaren Daten nicht kommentiert werden, gibt es bereits kommentierte Datensätze, um Emotionserkennungsforschung durchzuführen. Für die Klassifizierung verschiedener Emotionstypen aus multimodalen Quellen in Form von Texten, Audio, Videos oder physiologischen Signalen stehen folgende Datensätze zur Verfügung:

HUMAINE: bietet natürliche Clips mit Emotionswörtern und Kontextbeschriftungen in mehreren Modalitäten

Belfast-Datenbank: bietet Clips mit einer Vielzahl von Emotionen aus TV-Programmen und Interviewaufnahmen

SEMAINE: bietet audiovisuelle Aufnahmen zwischen einer Person und einem virtuellen Agenten und enthält Emotionsanmerkungen wie zornig, glücklich, Angst, Abscheu, Traurigkeit, Verachtung und Unterhaltung

IEMOCAP: bietet Aufnahmen von dyadischen Sitzungen zwischen Schauspielern und enthält Emotionsanmerkungen wie Glück, Ärger, Traurigkeit, Frustration und Neutralität

eNTERFACE: bietet audiovisuelle Aufnahmen von Motiven aus sieben verschiedenen Nationen und enthält emotionale Anmerkungen wie Glück, Wut, Trauer, Überraschung, Abscheu und Angst

DEAP: bietet Elektroenzephalographie (EEG), Elektrokardiographie (EKG) und Gesichtsvideoaufzeichnungen sowie Emotionsanmerkungen in Bezug auf Valenz, Erregung und Dominanz der Menschen, die sich Filmsequenzen ansehen

DREAMER: Dient zur Aufnahme von Elektroenzephalografie (EEG) und Elektrokardiographie (EKG) sowie Emotion-Annotationen in Bezug auf Valenz, Erregung und Dominanz der Zuschauer, die sich Filmsequenzen ansehen

Anwendungen

Die Computerprogrammierer verwenden häufig das Facial Action Coding System von Paul Ekman als Leitfaden.

Die Emotionserkennung wird aus verschiedenen Gründen eingesetzt. Affectiva hilft Werbetreibenden und Content-Erstellern dabei, ihre Produkte effektiver zu verkaufen. Affectiva stellt auch einen Q-Sensor her, der die Emotionen autistischer Kinder misst. Emotient war ein Startup-Unternehmen, das künstliche Intelligenz verwendete, um „Einstellungen und Handlungen basierend auf Gesichtsausdrücken“ vorherzusagen. Apple gab im Januar 2016 seine Absicht bekannt, Emotient zu kaufen. NViso bietet Echtzeit-Emotionserkennung für Web- und mobile Anwendungen über eine Echtzeit-API. Visage Technologies AB bietet die Emotionsschätzung als Teil des Visage SDK für Marketing, wissenschaftliche Forschung und ähnliche Zwecke an. Eyeris ist ein Unternehmen zur Emotionserkennung, das mit Embedded-System-Herstellern wie Automobilherstellern und Social-Robotic-Unternehmen zusammenarbeitet, um seine Gesichtsanalysen- und Emotionserkennungssoftware zu integrieren. sowie bei der Erstellung von Video-Inhalten, um die wahrgenommene Wirksamkeit ihres Kurz- und Langform-Videocreatives zu messen. Emotionserkennung und Emotionsanalyse werden weltweit von Unternehmen und Universitäten untersucht.

Lügenerkennung

Die Wahrnehmung der Wahrnehmung von Äußerungen durch multisensorische Emotionswahrnehmung ist hilfreich, insbesondere bei der Erkennung von Lügen, bei denen Lügen als absichtlich falsche täuschende Aussagen zu verstehen sind. Zwar ist dies kein allgemein gültiger Indikator für die Sicherheit von Lügen, Mimikry, Gesten, Sprache und Haltung können jedoch Anhaltspunkte geben. Relativ zuverlässig sind unbewusste oder nicht kontrollierbare Signale wie Pupillenbreite, Sichtlinie oder Erröten. Darüber hinaus sollte die Aufmerksamkeit zunehmend auf Diskrepanzen zwischen den verschiedenen verbalen und nonverbalen Ausdrücken einer Person gerichtet werden.