Reconocimiento de voz

El reconocimiento de voz es el subcampo interdisciplinario de lingüística computacional que desarrolla metodologías y tecnologías que permiten el reconocimiento y la traducción del lenguaje hablado en texto por computadora. También se conoce como reconocimiento automático de voz (ASR), reconocimiento de voz por computadora o voz a texto (STT). Incorpora el conocimiento y la investigación en los campos de la lingüística, la informática y la ingeniería eléctrica.

Algunos sistemas de reconocimiento de voz requieren «entrenamiento» (también llamado «inscripción») donde un hablante individual lee texto o vocabulario aislado en el sistema. El sistema analiza la voz específica de la persona y la usa para afinar el reconocimiento del habla de esa persona, lo que resulta en una mayor precisión. Los sistemas que no utilizan la capacitación se denominan sistemas «hablantes independientes». Los sistemas que usan entrenamiento son llamados «dependientes del hablante».

Las aplicaciones de reconocimiento de voz incluyen interfaces de usuario de voz como la marcación por voz (por ejemplo, «Llamada a casa»), enrutamiento de llamadas (por ejemplo, «Me gustaría hacer una llamada por cobrar»), control domótico de dispositivos, búsqueda (por ejemplo, encontrar un podcast donde se pronunciaran determinadas palabras) ), entrada de datos simple (p. ej., ingresar un número de tarjeta de crédito), preparación de documentos estructurados (p. ej., un informe de radiología), procesamiento de voz a texto (p. ej., procesadores de texto o correos electrónicos) y aeronaves (generalmente denominadas entrada de voz directa) .

El término reconocimiento de voz o identificación del hablante se refiere a identificar al hablante, en lugar de a lo que están diciendo. Reconocer al hablante puede simplificar la tarea de traducir el habla en sistemas que han sido entrenados en la voz de una persona específica o se puede usar para autenticar o verificar la identidad de un hablante como parte de un proceso de seguridad.

Desde la perspectiva tecnológica, el reconocimiento de voz tiene una larga historia con varias oleadas de innovaciones importantes. Más recientemente, el campo se ha beneficiado de los avances en el aprendizaje profundo y el big data. Los avances se evidencian no solo por el aumento de trabajos académicos publicados en el campo, sino también por la adopción de una variedad de métodos de aprendizaje profundo en la industria mundial para diseñar e implementar sistemas de reconocimiento de voz. Estos actores de la industria del habla incluyen Google, Microsoft, IBM, Baidu, Apple, Amazon, Nuance, SoundHound, iFLYTEK, muchos de los cuales han publicado la tecnología principal en sus sistemas de reconocimiento de voz como basados en el aprendizaje profundo.

Modelos, métodos y algoritmos.

Tanto el modelado acústico como el modelado de lenguaje son partes importantes de los algoritmos modernos de reconocimiento de voz basados en estadísticas. Los modelos ocultos de Markov (HMM) se usan ampliamente en muchos sistemas. El modelado de idiomas también se utiliza en muchas otras aplicaciones de procesamiento de lenguaje natural, como la clasificación de documentos o la traducción automática estadística.

Modelos ocultos de Markov

Los modernos sistemas de reconocimiento de voz de uso general se basan en los modelos ocultos de Markov. Estos son modelos estadísticos que dan salida a una secuencia de símbolos o cantidades. Los HMM se utilizan en el reconocimiento de voz porque una señal de voz puede verse como una señal estacionaria por partes o como una señal estacionaria de corto tiempo. En una breve escala de tiempo (por ejemplo, 10 milisegundos), el habla se puede aproximar como un proceso estacionario. El discurso puede considerarse como un modelo de Markov para muchos propósitos estocásticos.

Otra razón por la cual los HMM son populares es porque pueden ser entrenados automáticamente y son simples y computacionalmente factibles de usar. En el reconocimiento de voz, el modelo oculto de Markov emitiría una secuencia de vectores de valores reales n-dimensionales (siendo n un pequeño entero, como 10), generando uno de estos cada 10 milisegundos. Los vectores consistirían en coeficientes cepstrales, que se obtienen al tomar una transformada de Fourier de una breve ventana de tiempo y al decorrelar el espectro usando una transformada de coseno, y luego tomar los primeros coeficientes (los más significativos). El modelo oculto de Markov tenderá a tener en cada estado una distribución estadística que sea una mezcla de gaussianos de covarianza diagonal, lo que dará una probabilidad para cada vector observado. Cada palabra, o (para sistemas de reconocimiento de voz más generales), cada fonema, tendrá una distribución de salida diferente; se crea un modelo oculto de Markov para una secuencia de palabras o fonemas concatenando los modelos individuales entrenados de Markov ocultos para las palabras y los fonemas separados.

A continuación se describen los elementos centrales del enfoque más común, basado en HMM, para el reconocimiento de voz. Los sistemas modernos de reconocimiento de voz utilizan varias combinaciones de varias técnicas estándar para mejorar los resultados con respecto al enfoque básico descrito anteriormente. Un sistema de vocabulario amplio típico necesitaría la dependencia del contexto para los fonemas (por lo tanto, los fonemas con diferentes contextos izquierdo y derecho tienen diferentes realizaciones según los estados HMM); utilizaría la normalización de cepstral para normalizar diferentes condiciones de altavoz y grabación; para una mayor normalización del hablante, podría utilizar la normalización de la longitud del tracto vocal (VTLN) para la normalización de hombres y mujeres y la regresión lineal de máxima probabilidad (MLLR) para una adaptación más general del hablante. Las características tendrían los denominados coeficientes delta y delta-delta para capturar la dinámica del habla y, además, podrían utilizar el análisis discriminante lineal heteroscedástico (HLDA); o puede omitir los coeficientes delta y delta-delta y usar empalme y una proyección basada en LDA, tal vez seguida por un análisis discriminante lineal heteroscedástico o una transformada de covarianza global semi-vinculada (también conocida como transformada lineal de máxima verosimilitud o MLLT). Muchos sistemas utilizan las denominadas técnicas de entrenamiento discriminativo que prescinden de un enfoque puramente estadístico para la estimación de parámetros HMM y en su lugar optimizan alguna medida de los datos de entrenamiento relacionada con la clasificación. Los ejemplos son la información mutua máxima (MMI), el error de clasificación mínimo (MCE) y el error de teléfono mínimo (MPE).

La decodificación del habla (el término para lo que sucede cuando el sistema se presenta con una nueva expresión y debe calcular la oración fuente más probable) probablemente usaría el algoritmo Viterbi para encontrar la mejor ruta, y aquí hay una opción entre crear dinámicamente una Combinación del modelo de Markov oculto, que incluye tanto la información del modelo acústico como del lenguaje, y la combinación estática de antemano (el transductor de estado finito, o FST, enfoque).

Una posible mejora de la decodificación es mantener un conjunto de buenos candidatos en lugar de simplemente mantener al mejor candidato, y usar una función de mejor puntuación (volver a calificar) para calificar a estos buenos candidatos de modo que podamos elegir el mejor de acuerdo con esta puntuación refinada . El conjunto de candidatos se puede mantener como una lista (el enfoque de la N-mejor lista) o como un subconjunto de los modelos (una red). La re-puntuación se hace generalmente tratando de minimizar el riesgo de Bayes (o una aproximación del mismo): en lugar de tomar la oración de origen con la máxima probabilidad, tratamos de tomar la oración que minimiza la expectativa de una función de pérdida dada con respecto a todas las transcripciones posibles (es decir, tomamos la oración que minimiza la distancia promedio a otras oraciones posibles ponderadas por su probabilidad estimada). La función de pérdida suele ser la distancia de Levenshtein, aunque puede ser de diferentes distancias para tareas específicas; el conjunto de posibles transcripciones es, por supuesto, podado para mantener la capacidad de traccionamiento. Se han diseñado algoritmos eficientes para volver a puntuar las celosías representadas como transductores ponderados de estado finito con distancias de edición representadas a sí mismas como un transductor de estado finito que verifica ciertas suposiciones.

Reconocimiento de voz basado en Dynamic Time Warping (DTW)

La distorsión dinámica del tiempo es un enfoque que se utilizó históricamente para el reconocimiento de voz, pero ahora ha sido desplazado en gran medida por el enfoque basado en HMM más exitoso.

La distorsión dinámica del tiempo es un algoritmo para medir la similitud entre dos secuencias que pueden variar en el tiempo o la velocidad. Por ejemplo, se detectarán similitudes en los patrones de caminar, incluso si en un video la persona caminaba lentamente y si en otro caminaba más rápido, o incluso si hubiera aceleraciones y desaceleración durante el curso de una observación. DTW se ha aplicado a video, audio y gráficos; de hecho, cualquier dato que pueda convertirse en una representación lineal puede analizarse con DTW.

Una aplicación bien conocida ha sido el reconocimiento automático de voz, para hacer frente a diferentes velocidades de habla. En general, es un método que permite a una computadora encontrar una coincidencia óptima entre dos secuencias dadas (por ejemplo, series de tiempo) con ciertas restricciones. Es decir, las secuencias están «distorsionadas» de forma no lineal para coincidir entre sí. Este método de alineación de secuencias se utiliza a menudo en el contexto de los modelos ocultos de Markov.

Redes neuronales

Las redes neuronales surgieron como un enfoque atractivo de modelado acústico en ASR a fines de los años ochenta. Desde entonces, las redes neuronales se han utilizado en muchos aspectos del reconocimiento de voz, como la clasificación de fonemas, el reconocimiento de palabras aisladas, el reconocimiento de voz audiovisual, el reconocimiento de altavoces audiovisuales y la adaptación de altavoces.

A diferencia de los HMM, las redes neuronales no hacen suposiciones acerca de las propiedades estadísticas de las características y tienen varias cualidades que las hacen modelos de reconocimiento atractivos para el reconocimiento de voz. Cuando se usan para estimar las probabilidades de un segmento de características del habla, las redes neuronales permiten un entrenamiento discriminativo de una manera natural y eficiente. Pocas suposiciones sobre las estadísticas de las características de entrada se hacen con redes neuronales. Sin embargo, a pesar de su eficacia en la clasificación de unidades de tiempo corto, como los fonemas individuales y las palabras aisladas, las redes neuronales rara vez tienen éxito en las tareas de reconocimiento continuo, en gran parte debido a su falta de capacidad para modelar dependencias temporales.

Sin embargo, recientemente se han utilizado redes neuronales recurrentes LSTM (RNN) y redes neuronales de retardo de tiempo (TDNN) que han demostrado poder identificar dependencias temporales latentes y usar esta información para realizar la tarea de reconocimiento de voz.

También se estaban experimentando con Deep Neural Networks y Denoising Autoencoders para abordar este problema de manera efectiva.

Debido a la incapacidad de las redes neuronales avanzadas para modelar las dependencias temporales, un enfoque alternativo es utilizar las redes neuronales como un preprocesamiento, por ejemplo, transformación de características, reducción de dimensionalidad, para el reconocimiento basado en HMM.

Redes neuronales profundas y recurrentes.

Una red neuronal avanzada (DNN) es una red neuronal artificial con múltiples capas de unidades ocultas entre las capas de entrada y salida. Al igual que en las redes neuronales poco profundas, los DNN pueden modelar relaciones no lineales complejas. Las arquitecturas de DNN generan modelos de composición, donde las capas adicionales permiten la composición de características de capas más bajas, lo que brinda una gran capacidad de aprendizaje y, por lo tanto, la posibilidad de modelar patrones complejos de datos de voz.

Un éxito de los DNN en el reconocimiento de voz de vocabulario grande ocurrió en 2010 por investigadores industriales, en colaboración con investigadores académicos, donde se adoptaron grandes capas de salida del DNN basadas en estados HMM dependientes del contexto construidos por árboles de decisión. Vea revisiones exhaustivas de este desarrollo y del estado del arte a partir de octubre de 2014 en el reciente libro de Springer de Microsoft Research. Vea también los antecedentes relacionados con el reconocimiento automático de voz y el impacto de varios paradigmas de aprendizaje automático, incluido el aprendizaje profundo en artículos recientes.

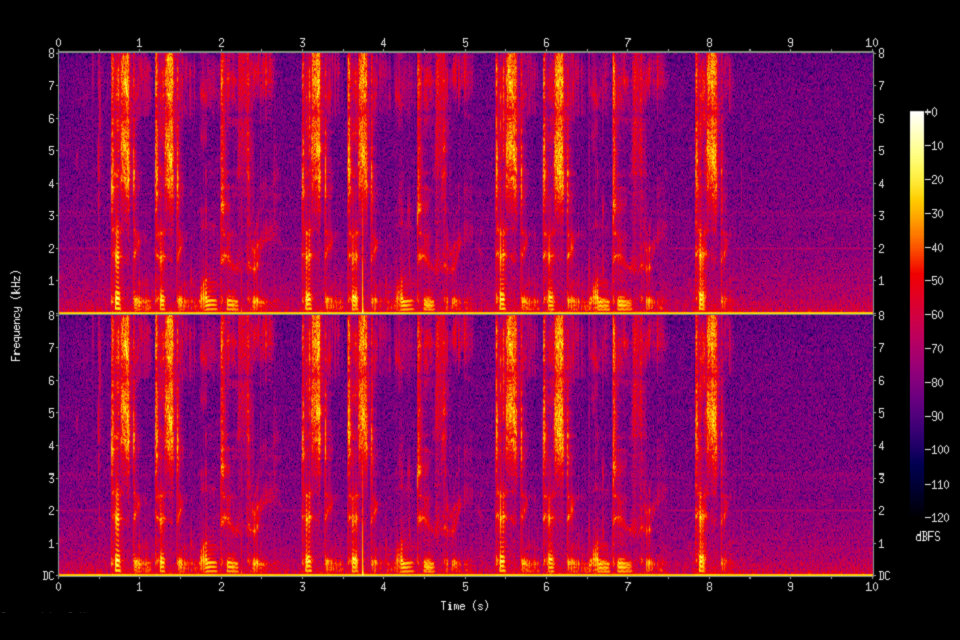

Un principio fundamental del aprendizaje profundo es eliminar la ingeniería de características hecha a mano y usar características en bruto. Este principio se exploró por primera vez con éxito en la arquitectura del autocodificador profundo en el espectrograma «sin procesar» o en las características lineales del banco de filtros, mostrando su superioridad sobre las características de Mel-Cepstral que contienen algunas etapas de transformación fija de los espectrogramas. Las verdaderas características «sin procesar» del habla, las formas de onda, se han demostrado más recientemente que producen excelentes resultados de reconocimiento de voz a gran escala.

Reconocimiento automático de voz de extremo a extremo

Desde 2014, ha habido mucho interés en la investigación de ASR «de extremo a extremo». Los enfoques tradicionales basados en la fonética (es decir, todos los modelos basados en HMM) requerían componentes y capacitación separados para el modelo de pronunciación, acústico y de lenguaje. Los modelos de extremo a extremo aprenden conjuntamente todos los componentes del reconocedor de voz. Esto es valioso ya que simplifica el proceso de capacitación y el proceso de implementación. Por ejemplo, se requiere un modelo de lenguaje de n-gramo para todos los sistemas basados en HMM, y un modelo de lenguaje típico de n-gramo a menudo requiere varios gigabytes en memoria, lo que hace que no sean prácticos de implementar en dispositivos móviles. En consecuencia, los sistemas comerciales modernos de ASR de Google y Apple (a partir de 2017) se implementan en la nube y requieren una conexión de red a diferencia del dispositivo local.

El primer intento de ASR de extremo a extremo fue con los sistemas basados en la Clasificación Temporal de Conexión (CTC) introducidos por Alex Graves de Google DeepMind y Navdeep Jaitly de la Universidad de Toronto en 2014. El modelo consistió en redes neuronales recurrentes y una capa de CTC. Conjuntamente, el modelo RNN-CTC aprende la pronunciación y el modelo acústico juntos, sin embargo, es incapaz de aprender el idioma debido a supuestos de independencia condicional similares a un HMM. En consecuencia, los modelos CTC pueden aprender directamente a asignar la acústica del habla a los caracteres en inglés, pero los modelos cometen muchos errores de ortografía comunes y deben confiar en un modelo de idioma separado para limpiar las transcripciones. Más tarde, Baidu amplió el trabajo con conjuntos de datos extremadamente grandes y demostró cierto éxito comercial en chino mandarín e inglés. En 2016, la Universidad de Oxford presentó LipNet, el primer modelo completo de lectura de labios de oraciones a nivel de oraciones, que utiliza convulsiones espaciotemporales combinadas con una arquitectura RNN-CTC, que superan el rendimiento a nivel humano en un conjunto de datos de gramática restringida.

Un enfoque alternativo a los modelos basados en CTC son los modelos basados en la atención. Los modelos ASR basados en la atención fueron introducidos simultáneamente por Chan et al. de Carnegie Mellon University y Google Brain y Bahdanaua et al. de la Universidad de Montreal en 2016. El modelo llamado «Listen, Attend and Spell» (LAS), literalmente «escucha» la señal acústica, presta «atención» a las diferentes partes de la señal y «deletrea» la transcripción de un personaje a la vez A diferencia de los modelos basados en CTC, los modelos basados en la atención no tienen supuestos de independencia condicional y pueden aprender todos los componentes de un reconocedor de voz, incluido el modelo de pronunciación, acústico y de lenguaje directamente. Esto significa que, durante la implementación, no es necesario llevar un modelo de lenguaje por lo que es muy práctico para la implementación en aplicaciones con memoria limitada. A finales de 2016, los modelos basados en la atención han tenido un éxito considerable, incluido el mejor desempeño de los modelos CTC (con o sin un modelo de idioma externo). Se han propuesto varias extensiones desde el modelo LAS original. La Carnegie Mellon University, MIT y Google Brain propusieron las descomposiciones de secuencias latentes (LSD, por sus siglas en inglés) para emitir directamente unidades de palabras secundarias que son más naturales que los caracteres ingleses; La Universidad de Oxford y Google DeepMind ampliaron el LAS para «Observar, escuchar, asistir y deletrear» (WLAS) para manejar la lectura de los labios y superar el rendimiento a nivel humano.

Aplicaciones

Sistemas de coche

Por lo general, una entrada de control manual, por ejemplo, por medio de un control con los dedos en el volante, habilita el sistema de reconocimiento de voz y esto se indica al conductor mediante un aviso de audio. Siguiendo el aviso de audio, el sistema tiene una «ventana de escucha» durante la cual puede aceptar una entrada de voz para el reconocimiento.

Se pueden usar comandos de voz simples para iniciar llamadas telefónicas, seleccionar estaciones de radio o reproducir música desde un teléfono inteligente compatible, reproductor de MP3 o unidad flash cargada de música. Las capacidades de reconocimiento de voz varían entre la marca y el modelo del automóvil. Algunos de los modelos de automóviles más recientes [¿cuándo?] Ofrecen reconocimiento de voz en lenguaje natural en lugar de un conjunto fijo de comandos, lo que permite al conductor utilizar oraciones completas y frases comunes. Con tales sistemas, por lo tanto, no es necesario que el usuario memorice un conjunto de palabras de comando fijas.

Cuidado de la salud

Documentacion medica

En el sector de la atención de la salud, el reconocimiento de voz puede implementarse en la parte delantera o en la parte posterior del proceso de documentación médica. El reconocimiento de voz de front-end es donde el proveedor dicta a un motor de reconocimiento de voz, las palabras reconocidas se muestran a medida que se hablan y el dictador es responsable de editar y firmar el documento. El reconocimiento de voz de fondo o diferido es donde el proveedor dicta un sistema de dictado digital, la voz se enruta a través de una máquina de reconocimiento de voz y el documento borrador reconocido se enruta junto con el archivo de voz original al editor, donde se edita el borrador. e informe finalizado. El reconocimiento de voz diferido se usa ampliamente en la industria actualmente.

Uno de los principales problemas relacionados con el uso del reconocimiento de voz en la atención médica es que la Ley de Reinversión y Recuperación de EE. UU. De 2009 (ARRA) proporciona beneficios financieros sustanciales a los médicos que utilizan un EMR de acuerdo con los estándares de «Uso significativo». Estas normas requieren que el EMR mantenga una cantidad sustancial de datos (ahora se conoce más comúnmente como un registro de salud electrónico o EHR). El uso del reconocimiento de voz se adapta más naturalmente a la generación de texto narrativo, como parte de una interpretación de radiología / patología, nota de progreso o resumen de alta: las ventajas ergonómicas de usar el reconocimiento de voz para ingresar datos discretos estructurados (por ejemplo, valores numéricos o códigos). de una lista o un vocabulario controlado) son relativamente mínimos para las personas que ven y que pueden operar un teclado y un mouse.

Un problema más importante es que la mayoría de los EHR no se han diseñado expresamente para aprovechar las capacidades de reconocimiento de voz. Una gran parte de la interacción del médico con el EHR implica la navegación a través de la interfaz del usuario mediante menús, y los botones de pestañas / botones, y depende en gran medida del teclado y el mouse: la navegación basada en la voz proporciona solo beneficios ergonómicos modestos. Por el contrario, muchos sistemas altamente personalizados para el dictado de radiología o patología implementan «macros» de voz, donde el uso de ciertas frases, por ejemplo, «informe normal», completará automáticamente un gran número de valores predeterminados y / o generará repetitivo. varía según el tipo de examen, por ejemplo, una radiografía de tórax frente a una serie de contraste gastrointestinal para un sistema de radiología.

Como una alternativa a esta navegación manual, el uso en cascada del reconocimiento de voz y la extracción de información se ha estudiado como una forma de completar un formulario de transferencia para la prueba clínica y la aprobación de la firma. Los resultados son alentadores, y el documento también abre datos, junto con los puntos de referencia de rendimiento relacionados y algunos programas de procesamiento, a la comunidad de investigación y desarrollo para estudiar la documentación clínica y el procesamiento del lenguaje.

Uso terapeutico

El uso prolongado del software de reconocimiento de voz junto con los procesadores de texto ha demostrado beneficios para el fortalecimiento de la memoria a corto plazo en pacientes con MAV en el cerebro que han sido tratados con resección. Es necesario realizar investigaciones adicionales para determinar los beneficios cognitivos para las personas cuyas MAV se han tratado con técnicas radiológicas.

Militar

Aviones de combate de alto rendimiento

Se han dedicado esfuerzos sustanciales en la última década a la prueba y evaluación del reconocimiento de voz en aviones de combate. De particular interés han sido el programa de reconocimiento de voz de los EE. UU. Para la aeronave FTI 16 / F-16 (F-16 VISTA), el programa en Francia para aviones Mirage y otros programas en el Reino Unido que tratan una variedad. de plataformas de aviones. En estos programas, los reconocedores de voz han sido operados con éxito en aviones de combate, con aplicaciones que incluyen: configurar frecuencias de radio, comandar un sistema de piloto automático, configurar coordenadas de punto de maniobra y parámetros de lanzamiento de armas, y controlar la pantalla de vuelo.

Al trabajar con pilotos suecos que volaban en la cabina de JAS-39 Gripen, Englund (2004) encontró que el reconocimiento se deterioró con el aumento de g-cargas. El informe también concluyó que la adaptación mejoró en gran medida los resultados en todos los casos y que se demostró que la introducción de modelos para la respiración mejoró significativamente las puntuaciones de reconocimiento. Contrariamente a lo que podría haberse esperado, no se encontraron efectos del inglés roto de los oradores. Era evidente que el habla espontánea causaba problemas para el reconocedor, como se podría haber esperado. Por lo tanto, podría esperarse que un vocabulario restringido, y sobre todo, una sintaxis adecuada, mejore sustancialmente la precisión del reconocimiento.

El Eurofighter Typhoon, actualmente en servicio con la RAF del Reino Unido, emplea un sistema dependiente de altavoces, que requiere que cada piloto cree una plantilla. El sistema no se usa para tareas críticas para la seguridad o para el uso de armas, como el lanzamiento o la bajada de armas del tren de aterrizaje, pero se usa para una amplia gama de otras funciones de la cabina. Los comandos de voz son confirmados por retroalimentación visual y / o auditiva. El sistema se considera una característica de diseño importante en la reducción de la carga de trabajo del piloto, e incluso permite al piloto asignar objetivos a su aeronave con dos comandos de voz simples o a cualquiera de sus pilotos de ala con solo cinco comandos.

Los sistemas independientes de los altavoces también se están desarrollando y están bajo prueba para el F35 Lightning II (JSF) y el entrenador principal de combate Alenia Aermacchi M-346. Estos sistemas han producido puntuaciones de precisión de palabras que superan el 98%.

Helicópteros

Los problemas de lograr una alta precisión de reconocimiento bajo estrés y ruido pertenecen en gran medida al entorno del helicóptero, así como al entorno del caza a reacción. El problema del ruido acústico es en realidad más grave en el entorno del helicóptero, no solo por los altos niveles de ruido sino también porque el piloto del helicóptero, en general, no usa una máscara facial, lo que reduciría el ruido acústico en el micrófono. En la última década se han llevado a cabo importantes pruebas y programas de evaluación en aplicaciones de sistemas de reconocimiento de voz en helicópteros, en particular por la Actividad de Investigación y Desarrollo de Aviónica del Ejército de los EE. UU. (AVRADA) y por el Real Establecimiento Aeroespacial (RAE) en el Reino Unido. El trabajo en Francia ha incluido el reconocimiento de voz en el helicóptero Puma. También ha habido mucho trabajo útil en Canadá. Los resultados han sido alentadores y las aplicaciones de voz han incluido: control de radios de comunicación, configuración de sistemas de navegación y control de un sistema automatizado de transferencia de objetivos.

Al igual que en las aplicaciones de caza, el problema principal de la voz en helicópteros es el impacto en la efectividad del piloto. Se informan resultados alentadores para las pruebas AVRADA, aunque éstas representan solo una demostración de viabilidad en un entorno de prueba. Queda mucho por hacer, tanto en el reconocimiento de voz como en la tecnología de voz en general, para lograr mejoras consistentes en el rendimiento en la configuración operativa.

Entrenamiento de controladores aéreos.

La capacitación para controladores de tráfico aéreo (ATC) representa una excelente aplicación para los sistemas de reconocimiento de voz. Muchos sistemas de entrenamiento de ATC actualmente requieren que una persona actúe como un «pseudo piloto», participando en un diálogo de voz con el controlador en entrenamiento, que simula el diálogo que el controlador tendría que llevar a cabo con los pilotos en una situación de ATC real. El reconocimiento de voz y las técnicas de síntesis ofrecen la posibilidad de eliminar la necesidad de que una persona actúe como pseudo piloto, reduciendo así la capacitación y el personal de apoyo. En teoría, las tareas del controlador de aire también se caracterizan por el habla altamente estructurada como la salida principal del controlador, por lo que debería ser posible reducir la dificultad de la tarea de reconocimiento de voz. En la práctica, esto rara vez es el caso. El documento 7110.65 de la FAA detalla las frases que deben usar los controladores de tránsito aéreo. Si bien este documento proporciona menos de 150 ejemplos de tales frases, el número de frases admitidas por uno de los sistemas de reconocimiento de voz de los proveedores de simulación es superior a 500,000.

La USAF, el USMC, el Ejército de los EE. UU., La Armada de los EE. UU. Y la FAA, así como una serie de organizaciones internacionales de entrenamiento de ATC, como la Royal Australian Air Force y Civil Aviation Authorities en Italia, Brasil y Canadá están utilizando simuladores de ATC con reconocimiento de voz de una serie de diferentes proveedores

Telefonía y otros dominios

ASR es ahora un lugar común en el campo de la telefonía, y está cada vez más extendido en el campo de los juegos de ordenador y la simulación. A pesar del alto nivel de integración con el procesamiento de textos en la computación personal en general. Sin embargo, el ASR en el campo de la producción de documentos no ha visto el aumento esperado [¿por quién?] En el uso.

La mejora de la velocidad del procesador móvil ha hecho que el reconocimiento de voz sea práctico en los teléfonos inteligentes. La voz se utiliza principalmente como parte de una interfaz de usuario, para crear comandos de voz predefinidos o personalizados. Los principales proveedores de software en este campo son: Google, Microsoft Corporation (Microsoft Voice Command), Digital Siphon (Sonic Extractor), LumenVox, Nuance Communications (Nuance Voice Control), Voci Technologies, VoiceBox Technology, Speech Technology Center, Vito Technologies (VITO Voice2Go ), Speereo Software (Speereo Voice Translator), Verbyx VRX y SVOX.

Uso en la educación y en la vida cotidiana.

Para el aprendizaje de idiomas, el reconocimiento de voz puede ser útil para aprender un segundo idioma. Puede enseñar una pronunciación adecuada, además de ayudar a una persona a desarrollar fluidez con sus habilidades para hablar.

Los estudiantes que son ciegos (vea Ceguera y educación) o que tienen muy poca visión pueden beneficiarse del uso de la tecnología para transmitir palabras y luego escuchar la recitación de la computadora, así como usar una computadora al mandar con su voz, en lugar de tener que mirar La pantalla y el teclado.

Los estudiantes con discapacidades físicas o que sufren lesiones por esfuerzo repetitivo / otras lesiones en las extremidades superiores pueden aliviarse al tener que preocuparse por escribir a mano, escribir o trabajar con el escriba en las tareas escolares mediante el uso de programas de voz a texto. También pueden utilizar la tecnología de reconocimiento de voz para disfrutar libremente buscando en Internet o usar una computadora en casa sin tener que operar físicamente un mouse y un teclado.

El reconocimiento de voz puede permitir que los estudiantes con discapacidades de aprendizaje se conviertan en mejores escritores. Al decir las palabras en voz alta, pueden aumentar la fluidez de su escritura y ser aliviados de las preocupaciones con respecto a la ortografía, la puntuación y otros mecanismos de escritura. También, vea Discapacidad de aprendizaje.

El uso de software de reconocimiento de voz, junto con una grabadora de audio digital y una computadora personal con software de procesamiento de palabras, ha demostrado ser positivo para restaurar la capacidad dañada de la memoria a corto plazo, en personas con accidente cerebrovascular y craneotomía.

Gente con discapacidades

Las personas con discapacidad pueden beneficiarse de los programas de reconocimiento de voz. Para las personas sordas o con problemas de audición, el software de reconocimiento de voz se utiliza para generar automáticamente subtítulos de conversaciones, como discusiones en salas de conferencias, conferencias en el aula y / o servicios religiosos.

El reconocimiento de voz también es muy útil para las personas que tienen dificultades para usar sus manos, que van desde lesiones leves por estrés repetitivo hasta discapacidades que impiden el uso de dispositivos de entrada de computadora convencionales. De hecho, las personas que utilizaron mucho el teclado y desarrollaron RSI se convirtieron en un mercado urgente para el reconocimiento de voz. El reconocimiento de voz se usa en la telefonía para sordos, como el correo de voz al texto, los servicios de retransmisión y el teléfono con subtítulos. Las personas con discapacidades de aprendizaje que tienen problemas con la comunicación de pensamiento a papel (esencialmente piensan en una idea, pero se procesa incorrectamente, lo que hace que el papel sea diferente) pueden beneficiarse del software, pero la tecnología no es a prueba de errores. Además, la idea de hablar con texto puede ser difícil para las personas con discapacidad intelectual debido al hecho de que es raro que alguien intente aprender la tecnología para enseñar a la persona con discapacidad.

Este tipo de tecnología puede ayudar a las personas con dislexia, pero otras discapacidades aún están en duda. La efectividad del producto es el problema que impide que sea efectivo. Aunque un niño puede ser capaz de decir una palabra dependiendo de lo clara que sea, la tecnología puede pensar que está diciendo otra palabra e ingresar la incorrecta. Dándoles más trabajo para arreglar, lo que hace que tengan que tomarse más tiempo para corregir la palabra incorrecta.

Otras aplicaciones

Aeroespacial (p. Ej., Exploración espacial, naves espaciales, etc.) Mars Polar Lander de la NASA utilizó tecnología de reconocimiento de voz de Sensory, Inc. en el Micrófono de Marte en el Lander

Subtitulación automática con reconocimiento de voz.

Reconocimiento automático de emociones

Traducción automática

Informes judiciales (redacción de discursos en tiempo real)

eDiscovery (descubrimiento legal)

Computación manos libres: interfaz de usuario de reconocimiento de voz para computadora

Automatización del hogar

Respuesta de Voz Interactiva

Telefonía móvil, incluido el correo electrónico móvil.

Interacción multimodal

Evaluación de la pronunciación en aplicaciones de aprendizaje de idiomas por ordenador.

Subtítulos en tiempo real

Robótica

Discurso a texto (transcripción de un discurso a texto, subtítulos de video, informes de la Corte)

Telemática (por ejemplo, sistemas de navegación de vehículos)

Transcripción (voz digital a texto)

Videojuegos, con Tom Clancy’s EndWar y Lifeline como ejemplos prácticos.

Asistente virtual (por ejemplo, Siri de Apple)

Actuación

El rendimiento de los sistemas de reconocimiento de voz generalmente se evalúa en términos de precisión y velocidad. La precisión se suele calificar con una tasa de error de palabra (WER), mientras que la velocidad se mide con el factor de tiempo real. Otras medidas de precisión incluyen la tasa de error de una sola palabra (SWER) y la tasa de éxito del comando (CSR).

Sin embargo, el reconocimiento de voz por la máquina es un problema muy complejo. Las vocalizaciones varían en términos de acento, pronunciación, articulación, aspereza, nasalidad, tono, volumen y velocidad. La voz está distorsionada por un ruido de fondo y ecos, características eléctricas. La precisión del reconocimiento de voz puede variar con lo siguiente:

Tamaño de vocabulario y confusibilidad.

Dependencia del hablante versus independencia

Habla aislada, discontinua o continua.

Restricciones de tareas y lenguaje

Lectura versus habla espontánea

Condiciones adversas